Temas Complementarios

Introducción

Este tema es una pequeña recopilación de posibles preguntas secundarias, bien dentro del desarrollo principal del ejercicio, como puede ser un centro de soporte (CAU), como de esas preguntas ‘freaks’ de las últimas tendencias tecnológicas o de gestión de sistemas de información.

Aunque no son prioritarias en el ejercicio, es importante prepararlas y practicarlas, aunque solamente os dejaremos los elementos principales o claves para que podáis profundizar por vuestra cuenta.

Servicios

Soporte al usuario

En el ejercicio tanto por ser parte de alguna pregunta, como por iniciativa propia, puede ser necesario incluir los servicios de soporte al usuario, bien sea interno (CAU) como externo (CAC). En el mismo, se tendrá en cuenta el soporte al mantenimiento (errores y pequeñas mejoras) al desarrollo de los sistemas de información.

Cuando pensamos en el CAU, es importante tener en cuenta:

- Herramienta a utilizar (licencias): existen multitud de herramientas para resolver esta función, que es bastante estándar entre organizaciones. Se basan generalmente en soluciones en “nube” (cada vez más frecuentes) u “on premises” (que están siendo relegadas a soluciones de código abierto con instalaciones y adaptaciones propias). Dado que es una función de soporte que generalmente no está en la cadena de valor de la organización, suele optarse por reducir el coste del personal de mantenimiento con soluciones en cloud.

Las licencias suelen estar ligadas al número de “agentes” (personas en atención a usuario simultáneamente).

En el caso de la Administración, si hablamos del CAC, podemos tener en cuenta el servicio compartido del 060 (Tema 5), que proporcionará algunos medios adicionales:

- Líneas telefónicas de atención.

- Sistema de distribución de llamadas.

- Sistemas de apoyo a la grestión del servicio.

- Contestador automático y enrutadores de llamadas.

Ejemplos de herramientas para el CAU:

- ServiceDeskPlus

- Remedy

- Footprints

- Jira

No hace falta hablar de tecnología si no se pide, pero lleva preparadas algunas herramientas por si exigen definirse, o si para tu solución concreta quieres ofrecer una solución tecnológica. En estos casos, considera:

Herramientas ya implementadas en el Ministerio.

Proporcionalidad en la solución.

Tecnología planteada en tu solución.

Si es “en la nube” o soluciones alojadas por nosotros mismos (“on premises”).

Los costes de mantenimiento y administración.

Tipos de incidencias habituales en el servicio:

- Problemas con los equipos informáticos.

- Accesos a sistemas y aplicaciones.

- Incidencias con equipos y aplicaciones.

- Peticiones de nuevas funcionalidades.

- Peticiones de material, asistencia, uso de equipamiento específico como salas de reuniones.

ITIL como metodología. Revisar el tema de ITIL puesto que tiene consideraciones de mucho valor sobre los aspectos de la Gestión del Servicio, así como procesos específicos para la gestión de incidencias, gestión de cambios, gestión de la configuración y soporte. También METRICA-3 tiene un proceso definido para el mantenimiento.

Métodos de contacto disponibles: teléfono, correo electrónico, sistemas de mensajería instantánea (TEAMS, Jabber), aplicaciones web.

Acceso a los datos de producción o protegidos de los distintos niveles, así como la gestión de autorizaciones y accesos.

ANSs de los niveles de atención, generalmente expresados en KPI con formas similares a esta:

El nivel 1 deberá dar clasificar y dar una primera respuesta en menos de 30’ en el 90% de las veces.

El ratio de reapertura de incidencias críticas debe ser inferior al 5%.

El ratio de reclasificaciones de las incidencias debido a una incorrecta clasificación inicial debe ser inferior al 15%.

Niveles de atención/soporte

Primer nivel: recepción y clasificación de las incidencias o peticiones. Realiza una primera resolución para casos muy sencillos, respuestas pre-establecidas o casos conocidos y documentados en la base de datos de conocimiento. También coordinan la respuesta en caso de requerir varios equipos técnicos y se ponen en contacto con los solicitantes para recabar más información o informar del estado.

Segundo nivel: solución de la incidencia o petición por el equipo técnico que corresponda según sea la necesidad.

Tercer nivel o nivel decisorio o de escalado → en algunos organismos, serán funcionarios, de los que se puede requerir el tomar decisiones con respecto a la estrategia de resolución, autorizar acciones que comporten un gasto o afecten a la seguridad, o presenten una dificultad que el CAU no pueda gestionar.

Cuarto nivel: proveedores de soporte externo, otros organismos, etc. En este caso, se requiere la intervención de fabricantes, gestión de garantías de desarrollos o productos, requerimientos a personal de otras organizaciones, etc.

CAU VIP: en muchas ocasiones para dar un servicio personalizado a los altos cargos, se forma el equipo del CAU VIP.

Dimensionamiento del CAU

- Primer nivel:

Suponiendo que el 40% de los usuarios totales sufre incidencias a lo largo del año de funcionamiento, obtenemos el número total de incidencias al año.

Suponiendo una distribución homogénea de incidencias a lo largo del año (240 días hábiles) y un horario de atención de 8 horas diarias, obtenemos las incidencias a la hora.

Suponiendo un tiempo mínimo de atención en 1° nivel de 15 minutos por incidencia.

- Segundo nivel

Se estima que únicamente el 25% del número total de incidencias superará el 1° nivel. Así obtenemos el número de incidencias que se van a atender en el 2° nivel.

Suponemos un tiempo de resolución de media hora por incidencia, y obtenemos los agentes de segundo nivel.

Agentes in Situ (OIS): se estima que el 25% de las incidencias recibidas por los especialistas del 2° nivel requerirán la atención por un OIS.

Tecnologias

Streaming

Para servir contenido multimedia se puede usar la red de contenidos Akamai, con capacidad de generar streaming en tiempo real en HD. Por lo general, ya nadie usa sistemas propietarios.

Tecnologías emergentes

Hay que estar al día de las últimas tendencias tecnológicas y su aplicación a las AAPP, desde la inteligencia artificial, IoT, voto electrónico, o cualquier otro que pueda servirnos para diferenciarnos en el ejercicio. Es posible que sea una de las preguntas freaks del final, o simplemente que estén ahí como pista para incluirlas en nuestra solución desde el principio. ¡Hay que estar muy atent@!

Además hay que tener en cuenta la estrecha relación que hay entre algunas de estas tecnologías. Por ejemplo, las soluciones de inteligencia artificial no se entienden en muchos casos sin los volúmenes masivos de datos sobre los que los algoritmos aprenden.

En cuanto a la contratación, cuando se realizan proyectos que requieren la licitación de tecnologías emergentes, es posible valorar la posibilidad de emplear la figura de contratación por asociación para la innovación. En la Plataforma de Contratación del Sector Público se puede encontrar algún ejemplo real del uso de esta figura.

Aunque no os desanimamos a que la empleéis, debéis tener un conocimiento detallado de los pasos a seguir y sobre todo, de los supuestos contemplados en este tipo de contrato.

Estos servicios son ofrecidos por los grandes proveedores como Microsoft (Azure), Google o Amazon (AWS). Son servicios en la nube, que se pueden contratar a través de los mecanismos explicados en el apartado de contratación.

El plan de transformación digital de la AGE 21-23 es una fuente para poder saber por dónde van los tiros.

Tener controlado el plan de transformación digital de la AGE 21-23 puede ser básico y decisivo a la hora de decantarnos por una solución en el ejercicio. Nos va a dar una visión de cuáles son las líneas de acción presentes y futuras de las AAPP, y por tanto muy útil para los ejercicios 3º y 4º.

BigData

La primera pregunta a hacerse es si se justifica o no la utilización de un sistema BigData. La respuesta viene dada por el hecho de si se han de manejar una combinación de, al menos, tres de las 4 V’s (Variabilidad, Volumen, Velocidad, Veracidad/ Validez)

Ojo con poner a la vez un cuadro de mando con un DHW clásico y a la vez un BIG DATA, duplicamos esfuerzos.

En cuanto a los productos a proponer en el simulacro, el volumen de tecnologías es inabordable. Existen muchísimas combinaciones y posibilidades

Como en el resto de casos, lleva unos cuantos preparados, con los que te sientas cómod@ y abordando distintas posibilidades para poder dar respuesta en cualquier ejercicio que nos puedan poner.

Los 3 grandes grupos de tecnología BigData son:

Hadoop/MapReduce: hadoop hdfs, hadoop mapreduce, hive, etc..

Bases de datos NoSQL: Mongodb,cassandra, neo4j, etc...

Bases de datos relacionales extendidas: Vertica, Pivotal, etc ...

MapReduce nace de los principios conocidos desde los años ochenta de la computación distribuida. Es un modelo de programación para dar soporte a la computación paralela sobre grandes colecciones de datos en grupos de computadoras y al commodity computing.

Dentro de las BBDD NoSQL cabe mencionar las basadas en documentos, columnas o grafos.

La que se representa a continuación es únicamente un ejemplo de pilas de tecnología asociadas a BigData. Si aprendéis el modelo, os puede servir de ahora en adelante para cualquier solución de este tipo.

HDFS Hadoop Distributed File System es un sistema de archivos distribuido, escalable y portátil escrito en Java para el framework Hadoop.

HBase es una base de datos distribuida no relacional de código abierto modelada a partir de Google BigTable y escrita en Java.

MongoDB, base de datos escrita en código abierto, orientada a documentos, que utiliza estructuras BSON, similares a JSON.

ZooKeeper, servicio de coordinación de código abierto distribuido para aplicaciones distribuidas.

Apache flume, es un servicio distribuido, fiable y altamente disponible para recopilar, agregar y mover eficientemente grandes cantidades de datos.

Sqoop es una aplicación con interfaz de línea de comando para transferir datos entre bases de datos relacionales y Hadoop. Mahout es el sistema de Machine Learning (Aprendizaje automático).

Apache Hive es una infraestructura de almacenamiento de datos consturida sobre Hadoop para proporcionar agrupación, consulta y análisis de datos.

Pig, plataforma para el análisis de grandes conjuntos de datos.

Apache Drill es un framework open source que admite aplicaciones distribuidas de uso intensivo de datos para el análisis interactivo de conjuntos de datos a gran escala.

Apache Storm, sistema de computación en tiempo real, distribuido, libre y de código abierto.

Si proponéis una solución de Big Data, tened en cuenta que en el diagrama físico deberéis proponer, al menos, un Servidor Hadoop (en la parte de Servidores de aplicaciones) y una base de datos no relacional en la parte correspondiente al almacenamiento de datos. Igualmente, el diagrama lógico, deberá tener en cuenta la base de datos no relacional en la capa de acceso a datos y un módulo genérico de BigData/Hadoop en la capa de Negocio, para ser consecuente con vuestra decisión de usar BigData en vuestra solución

IA

Es básico tener en cuenta en nuestras propuestas los aspectos normativos:

Comunicación de la Comisión al Parlamento Europeo, al Consejo Europeo, al Consejo, al Comité Económico y Social Europeo y al Comité de las Regiones relativo a la Inteligencia Artificial para Europa COM (2018) 237 final relativa a la necesidad de elaborar y desarrollar la normativa apropiada que establezca el marco legal relativo a la implantación y al uso de la IA dentro de la Administración Pública. Este plan establece que los estados miembros de la UE deberán aprobar, a lo largo de 2019, una 'Estrategia Nacional para la Inteligencia Artificial'.

En marzo de 2019, se ha presentado en España “La Estrategia para la Inteligencia Artificial en I+D+I”, que, aunque pudiese parecer, por la similitud de nombres, que sea la estrategia que pide la Unión Europea, no es el caso. Tal como han reconocido el Presidente del Gobierno y el Ministro de Ciencia, Innovación y Universidades, esta estrategia es el primer paso o el embrión de lo que será la Estrategia Nacional de Inteligencia Artificial.

No debemos confundir INTELIGENCIA ARTIFICIAL con AUTOMATIZACIÓN DE PROCESOS

De forma muy simplificada, automatización es que una máquina, en base a unos parámetros de entrada, realiza un proceso definido y conocido y devuelve una salida. Sin embargo, en procesos de INTELIGENCIA ARTIFICIAL, una máquina realiza un aprendizaje a partir de una muestra, y, a partir de ahí, es capaz de recibir una entrada distinta o desconocida hasta ahora y en base a su aprendizaje, tomar una decisión.

Procesos de inteligencia artificial son los relativos por ejemplo a Machine learning, donde a partir de una muestra, el algoritmo aprende que es lo que tiene que identificar y hacer y, una vez hecho, es capaz de recibir una nueva entrada y en base a su conocimiento dar una respuesta.

Un caso muy simple, tenemos un conjunto de documentos, que hablan de aspectos relativos a cada Ministerio (unos documentos hablan de carreteras, otros de sanidad, otros de cultura, etc.) y ya se dispone de una muestra de 1 millón de documentos relacionados con su correspondiente Ministerio. Mediante procesos de machine learning, se podría entrenar un algoritmo para que, en base a la muestra fuese capaz de identificar el contenido de cada documento con su Ministerio, de forma que cuando llegase un nuevo documento con su conocimiento adquirido, supiese inferir cual es el Ministerio más probable al que corresponde.

Automatización de procesos - RPA

Para preparar este apartado, te puedes guiar por el PLAN DE DIGITALIZACIÓN DE LAS AAPP: EJE 1: TRANSFORMACIÓN DIGITAL -> 3.2. AUTOMATIZACIÓN INTELIGENTE DE PROCESOS -> MEDIDA 5. Servicio de automatización Inteligente

Aunque basado en la inteligencia artificial últimamente, se trata de una tecnología que ya existía con anterioridad cuyo objetivo es sustituir al ser humano en las tareas repetitivas del PAC.

Blockchain

Blockchain es un tipo de arquitectura transaccional DTL (Distributed Transaction Ledger) basada en un libro contable o ledger distribuido, formado por una base de datos transaccional que se comparte y sincroniza para todos los nodos de una red descentralizada, sin autoridad central.

Blockchain almacena la base de datos de transacciones en una estructura de cadena de bloques. Cada transacción o grupo de transacciones que forman un bloque tienen una marca de tiempo y una firma criptográfica asociada (hash), convirtiendo a este registro en inalterable y auditable por cualquiera que necesite verificar que esas transacciones son reales y que no han sido modificadas.

En el mundo empresarial está comenzando a aplicarse no sólo a las transacciones económicas (su uso original fue Bitcoins), sino a cualquier ámbito dado su potencial.

| Tipos de Blockchain | |||

|---|---|---|---|

| Pública | Consorcio | Privada | Híbrida |

| No hay restricciones ni para leer los datos de la blockchain ni para enviar transacciones a la cadena de bloques. Se construyen con la idea de que el entorno es no confiable. Se usan para aplicaciones que deben operar sobre Internet | Es una blockchain similar a la pública (a menudo usa características de alguna pública) pero con acceso solamente para los nodos pertenecientes al consorcio en cuestión. | Tanto los accesos a los datos de la blockchain como el envío de transacciones para ser incluidas están limitadas a una lista predefinida de nodos pertenecientes a una organización, que es la que mantiene la infraestructura de la blockchain. | Una combinación entre pública y privada. Algunos datos se comparten entre todos los nodos y otros se mantienen sólo para aquellos nodos autorizados. |

Plataformas para desarrollar blockchain

Existen plataformas (Ethereum, Ripple, Quorum, Corda, NEM, Hyperledger Fabric …) que permiten el uso de blockchain en los sistemas, entre ellas destacar:

Ethereum - plataforma opensource que permite desarrollar blockchain con implementación de Smart Contracts.

Hyperledger - plataforma de código abierto como la de Ethereum, pero está dirigida a proyectos en entornos empresariales.

Algunas iniciativas y usos para la Administración

En el ámbito de la administración todavía se están analizando sus posibilidades y cómo implementarlo. En España, la Comunidad Autónoma de Aragón, ya ha comenzado a utilizarlo en los procesos de contratación pública, de forma que utilizarán blockchain para el registro de ofertas por parte de los licitadores de contratación pública en el marco de procedimientos abiertos simplificados.

Hay un grupo europeo que trabaja para estudiar el uso de esta tecnología en las AA.PP. europeas, y un grupo de trabajo dentro de la AGE. Uno de los pilotos o proyectos dentro de este grupo se realiza con el Ministerio de Universidades, para la gestión digital de titulaciones universitarias, bajo una infraestructura blockchain.

Otros ejemplos de uso por las administraciones de esta tecnología:

Estonia: Estonia es paradigma de la transformación digital de un Gobierno. El país está desplegando un sistema de Blockchain para agilizar la compartición de diversos tipos de datos entre la Administración Pública (de carácter legal, jurídico, etc.), así como su protección y seguridad, y la transparencia. Básicamente, el funcionamiento es que cada vez que se comparte información entre administraciones, queda anotada la consulta, de forma que nadie ni nada puede negar la realización de esta.

Unión europea. DECODE Project. (Está en fase piloto). los ciudadanos podrán decidir qué hacer y cómo gestionar sus datos en un escenario de mayor transparencia, automatización y digitalización de los datos de las ciudades e identidades, así como el impacto económico que podría generar en estas ciudades.

Procesos Electorales. El sistema de encriptado de datos y la seguridad en las comunicaciones en los que se basa la cadena de bloques la convierte en una oportunidad para impulsar las bases de un modelo electoral digital que garantice la fiabilidad de las votaciones a través de Internet, una de las grandes apuestas para un nuevo modelo de gobernanza.

Información Sanitaria Protegida. Mediante blockchain se puede garantizar la privacidad de los datos sanitarios y posibilita su acceso compartido entre centros hospitalarios para, de esta manera, evitar la duplicidad o los datos erróneos en los historiales médicos. Mediante blockchain se puede asegurar la fiabilidad de los datos.

Intercambio Fiable De Información Entre Administraciones. De forma similar a la información sanitaria es aplicable a la información que comparten las administraciones relativas a los ciudadanos, para garantizar su seguridad y la no alteración de la misma.

Identidad Digital. Los últimos y gigantescos fallos de seguridad y robos de datos han hecho que la gestión de nuestras identidades se convierta en un problema muy real. Blockchain podría proporcionar un sistema único para lograr validar identidades de forma irrefutable, segura e inmutable.

Registros: Cualquier tipo de registro, por ejemplo, el Registro Civil, podría implantarse con esta tecnología y garantiza la seguridad, inmutabilidad de los datos… Otros ejemplos serían el Catastro y las escrituras de viviendas/terrenos etc.

Datalake - Analítica avanzada

Las tecnologías que hemos visto hasta ahora, Big Data, IA…posibilitan el manejo y transformación de grandes cantidades de datos, así como la aplicación de complejos algoritmos matemáticos adaptados a los distintos problemas que se abordan.

Estos nuevos paradigmas tienen unos altos requisitos de computación, almacenamiento, escalabilidad y flexibilidad en la creación de modelos automatizados, lo que obliga a redefinir las infraestructuras de provisión de este tipo de servicios. Así de forma muy resumida, las infraestructuras, generalmente en la nube, para dar soporte a estos procesos, son el DataLake.

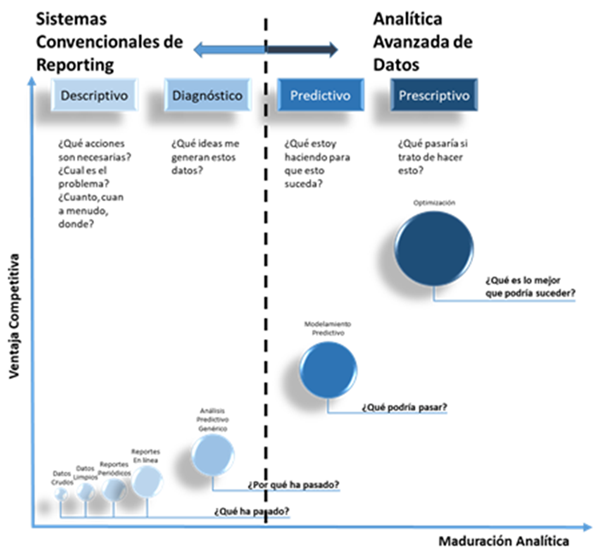

En el siguiente gráfico se muestra las necesidades de información, a partir de las cuales se justifica la puesta en marcha de un sistema de Analítica Avanzada de datos:

A continuación, se especifican los requisitos de los servicios necesarios para la construcción de dichas arquitecturas. Es preciso tener en cuenta que todos ellos deben ser totalmente integrables e interoperables entre ellos, y deben tener facilidades para la integración de soluciones de terceros.

Servicio:

- DataLake

Servicio de almacenamiento de objetos que ofrece escalabilidad, disponibilidad de datos, seguridad y alto rendimiento para todo tipo de volúmenes y tamaños (con los límites especificados en el apartado de dimensionamiento).

El servicio debe permitir almacenar y proteger cualquier cantidad de datos para diversos casos de uso, pero especialmente centrado en el análisis de datos, ya se trate de Smart Data o de Big Data. Para ello, los datos, ya partan de un origen estructurado, semi-estructurado o no estructurado, deben permitir almacenarse en formatos de acceso y manejo rápido y ágil, como csv o json, y formatos columnares específicos, como Apache Parquet, que permitan la interoperabilidad con cualquier proyecto del ecosistema Hadoop.

El servicio debe admitir diferentes niveles de acceso a los datos, de tal manera que se produzca un ahorro de costes asociado a aquellos datos cuyo uso es menos frecuente que otros y no tienen unos requisitos tan altos de tiempo de respuesta. En cualquier caso, se exige una durabilidad de los datos del 99,999999999 %.

La gestión y administración del servicio debe permitir, de forma sencilla, organizar los datos y configurar controles de acceso granularizados a nivel de objeto, y que permita una sencilla conexión con los servicios de gestión de identidades y roles.

- Ingesta de datos, DataFactory

Servicios que permitan la ingesta de datos en el Data Lake a través de distintas alternativas.

- Ingesta de archivos mediante programa de línea de comandos, con posibilidad de automatizar o programar las cargas.

- Servicio de migración de bases de datos de tecnologías heterogéneas, incluyendo al menos MySQL, PostgreSQL, MariaDB, SQL Server y Oracle.

- Posibilidad de ingesta de datos mediante envío de dispositivo físico

- BBDD relacionales

Servicio que permita la creación, gestión, utilización y escalado de instancias de bases de datos relacionales, incluyendo al menos MySQL, PostgreSQL, MariaDB, SQL Server y Oracle.

- BBDD NoSQL

Servicio que permita la creación, gestión utilización y escalado de instancias de bases de datos no relacionales, basadas en clave-valor y en documentos.

La base de datos debe ofrecer rendimiento en milisegundos de un solo dígito a cualquier escala. Además, la infraestructura debe permitir la construcción de bases de datos NoSQL alternativas, como MongoDB o Apache Cassandra

- Ingesta de datos en tiempo real

Servicio que permita realizar ingestas de datos en tiempo real con un alto nivel de escalabilidad y durabilidad.

Debe permitir la conversión automática de los datos entrantes en formatos en columnas, tales como Apache Parquet o Apache ORC, antes de que los datos se envíen al sistema de almacenamiento.

Los datos recogidos en streaming deben poderse recopilar desde fuentes de datos heterogéneas, internas o externas, y en cualquier tipo de formato.

- Batch

Servicio que permita la configuración, programación y ejecución de trabajos informáticos por lotes.

El servicio debe aprovisionar de manera dinámica la cantidad y el tipo óptimo de recursos informáticos en función del volumen y los requisitos específicos de recursos de los trabajos por lotes enviados.

El servicio debe permitir la ejecución de trabajos de duración indefinida, de manera que dicha duración no implique un sobrecoste adicional sobre los recursos empleados.

- Computacion

Servicio que permita el suministro de capacidad de proceso sobre máquinas virtuales que se ejecutan en la nube.

El servicio debe permitir un control completo sobre los recursos informáticos, permitiendo elegir entre diferentes tipos de máquinas y sistemas, incluyendo sistemas operativos Linux y Windows, y distintas capacidades de CPU, memoria RAM y disco.

El aprovisionamiento de instancias debe poder realizarse de diferentes maneras, de tal forma que se permita una adaptación a distintas casuísticas de negocio. Al menos, se debe recoger el aprovisionamiento bajo demanda, la reserva de instancias, reserva de instancias programadas y el aprovisionamiento spot, mediante subasta de capacidad informática sobrante en la nube.

- Implementación y escalado automático de aplicaciones y servicios

Servicio que permita la abstracción y escalado de las distintas instancias del sistema, de tal manera que se puedan desplegar directamente sobre él aplicaciones y servicios que precisen de una alta disponibilidad y de necesidades de escalado automático.

El servicio debe permitir el desarrollo de servicios sobre, como mínimo, los lenguajes Java, .NET, PHP, Node.js, Python, Ruby y Go, soportando el despliegue sobre Dockers, y los alojará en servidores como Apache, Nginx, Passenger e IIS.

La edición o despliegue del código fuente desarrollado debe permitir el uso de los sistemas de integración continua establecidos en el conjunto de la arquitectura.

- Gestión de contenedores Docker y Kubernetes

Servicios que permitan desarrollar tareas de almacenamiento, administración e implementación de imágenes de contenedores de Docker y Kubernetes. El servicio debe facilitar la integración de las imágenes de Docker y Kubernetes en los flujos de producción.

- Microservicios basado en eventos

Servicio de ejecución de código sin servidor, para la implementación de microservicios.

La activación de las ejecuciones debe lanzarse desde eventos configurables asociados a cualquier elemento del conjunto de la infraestructura, tanto entrada como salida debe ser totalmente integrable en los flujos de trabajo. La edición o despliegue del código fuente desarrollado debe poder realizarse en línea o mediante carga de un paquete a través de sistemas de integración continua establecidos en el conjunto de la arquitectura. Además, debe permitir el trabajo con capas para aislar y compartir dependencias entre las distintas aplicaciones y funciones desplegadas.

- Monitorización y Alertas

Servicios de monitorización de alertas y repositorio y gestión de logs. Deben permitir la programación de alertas y llamadas ligadas a eventos, así como una gestión de la configuración adaptable por el usuario. Los datos de monitoreo y operaciones deben ser recopilados en formato de registros, métricas y eventos, ofreciendo una vista unificada de los recursos globales.

- Implementación y gestión de flujos automáticos de trabajo

Servicio que permita la coordinación de múltiples servicios de la infraestructura en flujos de trabajo sin servidor. Los flujos de trabajo deben componerse de una serie de pasos, con la salida de un paso actuando como entrada en el siguiente. Debe permitir llamadas a servicios Lambda e instancias del sistema.

- Gestión de identidades

Servicio que debe permitir el acceso a los servicios y recursos ofrecidos por la nube, de forma segura. Debe permitir una gestión ágil y flexible de identidades a través de distintas capas: usuarios, roles y políticas.

Debe permitir un alto nivel de granularidad y un presentar un funcionamiento homogéneo y un sistema centralizado desde el que poder gestionar los accesos a todos los servicios disponibles.

- Gestión de autenticación entre servicios heterogéneos

Servicio que debe permitir integrar el acceso seguro a servicios y recursos externos que puedan ser instalados o integrados en la infraestructura. Debe permitir la gestión de grupos de usuarios y de identidades federadas y conectarse a sistemas de directorio corporativos populares como, por ejemplo, Active Directory de Microsoft.

- Visualización de datos y creación de cuadros de mando

Servicio que debe permitir el manejo de los datos almacenados, permitiendo su exploración, la creación de visualizaciones que incluyan gráficas estadísticas, mapas, diagramas y series temporales, todo ello parametrizable, y el diseño de cuadros de mando interactivos.

Además, debe permitir también la gestión de la información almacenada, a través de una consola y el desarrollo de plugins personalizables mediante código de scripting.

- API REST para llamada externa a servicios

Servicio que posibilite la configuración de puntos de acceso a servicios alojados en la red privada virtual que se construya en la nube para aquellas utilidades que deban estar a disposición de los usuarios.

El servicio debe permitir crear APIs REST y APIs WebSocket que actúen como "puerta delantera" para que las aplicaciones obtengan acceso a datos, lógica de negocio o funcionalidades residentes en los servicios backend.

- Entrega y distribución de contenidos

Servicio de entrega y distribución de contenido que permita publicar servicios y aplicaciones que deban estar accesibles a través de internet. Debe trabajar de forma segura, con baja latencia, altas velocidades de transferencia y dentro de un entorno sencillo para desarrolladores.

Además, debe ser integrable en los procesos y flujos de trabajo de integración continua definidos con el resto de herramientas del entorno.

Los tres grandes proveedores de servicios en la nube ofrecen servicios adaptables a las necesidades de las AAPP para la puesta en marcha de Sistemas de Analítica Avanzada de Datos en Inteligencia Artificial.

Internet de las cosas - 5G

Smart Cities → mejor servicio al ciudadano.

Carreteras inteligentes → Mejor servicio al ciudadano.

Redes de sensores → Incendios forestales, estados de las playas …

Gestión eficiente de las flotas de vehículos de las AAPP.

Voto electronico

Cuando hablamos de voto electrónico, tendremos que tener en cuenta ante todo:

- Confidencialidad, para que el sentido del voto no pueda ser espiado por terceros.

- Autentificación del votante y del sistema de voto.

- Integridad de contenidos para evitar que el voto pueda ser manipulado por terceros.

- No repudio, de forma que el votante no pueda negar que ha realizado el voto, y por tanto evitar votos duplicados.

- Disociación del voto-votante.

Revisa tanto el RGPD como la LOPDGDD para tener claro en todo momento la protección de datos y posibles tratamientos, ya no únicamente en la gestión del voto, sino en cualquier otro ejercicio que haga referencia a los ciudadanos, garantía de información, etc.

Otros

Informe ejecutivo

El objetivo de esta pregunta es realizar un informe, normalmente de alto nivel, y que realmente será la venta de nuestro examen.

Es importante tener en cuenta: ● Escribir en tercera persona y de forma imparcial. Por ejemplo una estructura de escenario actual escenario futuro - cómo llego allí. ● Extensión breve, de 1 o 1,5 páginas como mucho. ● Si es la primera pregunta del examen, será la venta de nuestro ejercicio, así que habrá que dedicarle tiempo. Causar una buena impresión inicial es importante.

No hace falta que respondas las preguntas en orden. Puede ser de gran utilidad dejarla para el final, así podrás incluir detalles de otras preguntas y mantener la coherencia (planificación, movilidad, etc), pero ¡¡¡ ojo con olvidarse !!!!

● Analiza el destinatario → Normalmente va dirigido a altos cargos, o un informe de alto nivel. En ese caso, es mejor no entrar en detalles tecnológicos. Si es para otro fin, trata de adecuarte al destinatario final.

● Contextualiza. Plasma la realidad actual en el ámbito al que afecte. Maneja los planes europeos, la Agenda 2030, etc, para poder aplicarlo en el contexto.

● Incluye algunos detalles estratégicos: ROI, ahorro, eficiencia, ventajas para ciudadano y aapp. Atentos a los detalles implícitos en el ejercicio! (campañas publicitarias, por ejemplo).

● Utiliza palabras del enunciado ¡pero no frases completas!.

● Recopila datos que puedan ser útiles como ahorro en trámites electrónicos, o la utilización de la administración digital por ciudadanos, o reutilización.

Si se puede y el ejercicio se presta a ello, puedes incluir una estimación de presupuesto y duración. En los informes a los altos cargos suele ser un dato esperable.

Analisis DAFO

El análisis FODA (Fortalezas, Oportunidades, Debilidades, Amenazas), también conocido como análisis DAFO, es una herramienta de estudio de la situación de una empresa, institución, proyecto o persona, analizando las características internas (Debilidades y Fortalezas) vs situación externa (Amenazas y Oportunidades) y plasmando los resultados en una matriz cuadrada.

Es una herramienta habitual tanto en un plan estratégico como en un plan de negocio o un estudio de mercado. Es una técnica indispensable para analizar y poner de relieve la situación actual de tu negocio, y poder tomar las decisiones estratégicas adecuadas.

[ INTERNO ] Debilidades - Aspectos limitadores de la capacidad de desarrollo de tu negocio, debido a características internas.

[ INTERNO ] Fortalezas - conjunto de recursos internos, posiciones de poder y cualquier tipo de ventaja competitiva propia de tu negocio.

[ EXTERNO ] Amenazas - factores externos que pueden llegar a impedir la ejecución de tu estrategia empresarial o poner en peligro la viabilidad de tu negocio.

[ EXTERNO ] Oportunidades - cualesquiera factores ajenos a tu negocio que favorecen su desarrollo o brindan la posibilidad de implantar mejoras.

Un ejemplo de matriz DAFO sería:

¡¡¡ Adapta el análisis DAFO al ejercicio !!! Eso sí, hay algunos elementos que puedes llevar preparados o con la práctica y agilidad suficientes para saber identificar de forma rápida los elementos de la matriz.

Factores críticos de exito

Los Factores Críticos de Éxito (FCE) son variables que se deben tomar en cuenta antes y durante la realización de un proyecto, ya que aportan información valiosa para alcanzar las metas y objetivos de la organización.

Características de los factores críticos de éxito:

Son temporales y particulares: pueden establecerse para un solo proyecto y luego no utilizarse para el siguiente. También es posible que los que determine una empresa no funcionen igual para otra del mismo sector.

Son pocos. Normalmente entre 2 y 6.

Necesarios para los objetivos de la organización o del proyecto.

Son un fin en sí mismo. Son objetivos, no la manera de alcanzar el objetivo.

Concebidos a la medida de cada proyecto.

Ejemplos de estos FCE podrían ser:

- Disponibilidad del sistema

- Implicación de la dirección

- Formación al personal

- etc

¡¡¡ Adapta el análisis FCE al ejercicio !!! Habrá elementos que puedan ser relativamente estándar o aplicables a varios casos prácticos, pero seguro que hay algo particular del ejercicio que lo hará específico.

Plan de continuidad

Puede basarse en el dominio 14 de la ISO 27001, Gestión de la continuidad de Negocio, donde se definen los controles de seguridad sobre este plan.

Se desarrolla un plan de Contingencia para los sistemas TIC, que se engloba dentro del Plan de Continuidad de Negocio (que engloba otros elementos como edificios, infraestructuras físicas, personas…).

El plan en sí se puede basar en los procedimientos de la norma BS25999-2 que es certificable, y un posible plan de cómo desarrollarlo sería el siguiente:

Dentro de la Planificación e Implementación hay que desarrollar una serie de tareas como:

Desarrollo del BIA (Bussiness Impact Analisis):

- Identificación de servicios y sus dependencias

- Infraestructura que los soporta

- Determinación de RTO y RPO

Desarrollo del Plan de Recuperación:

Plan de respuesta: Procedimientos de notificación, alertas, evaluación de daños, activación del plan, equipos y estructura organizativa…

Plan de Recuperación: estrategias y procedimientos para recuperar los sistemas, y su documentación

Formación y pruebas del Plan, que han de ser como mínimo anuales.

El modelo de continuidad elegido en cuanto al CPD (activo-activo, activo-pasivo…), debe ir en línea con vuestro nivel del ENS del sistema.